참고 1: https://realyun99.tistory.com/153

참고 2: https://realyun99.tistory.com/154

참고 3: https://realyun99.tistory.com/155

얼마 안남았다...! 마지막 lab!!

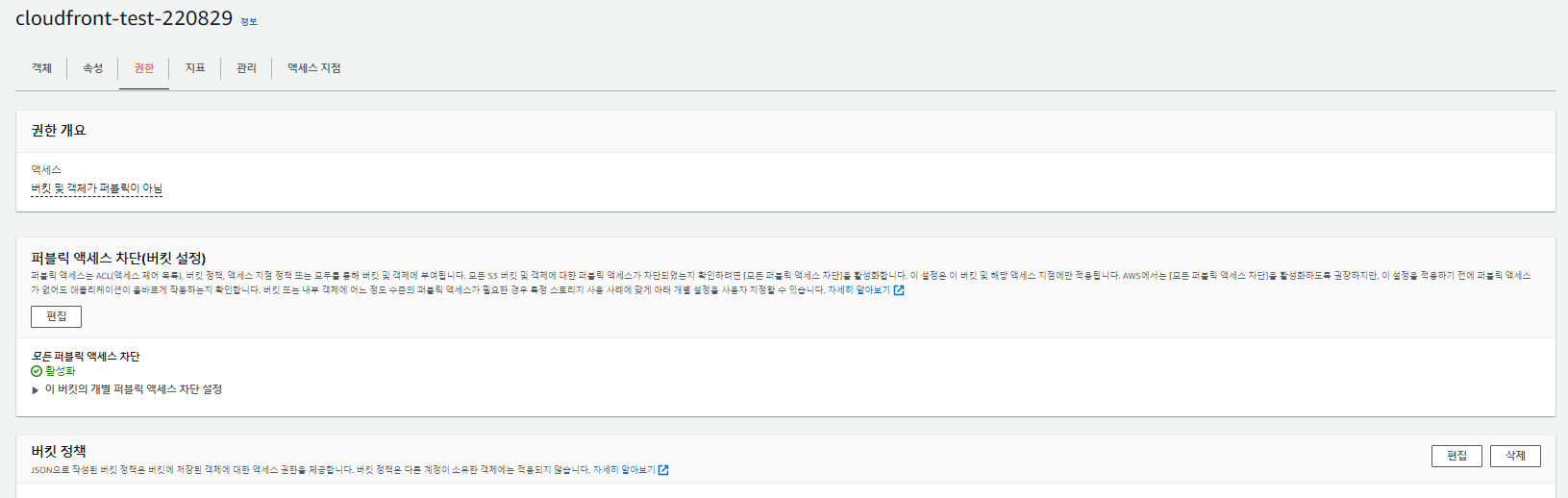

- S3 버킷

버킷을 생성한다.(나머진 default로 진행)

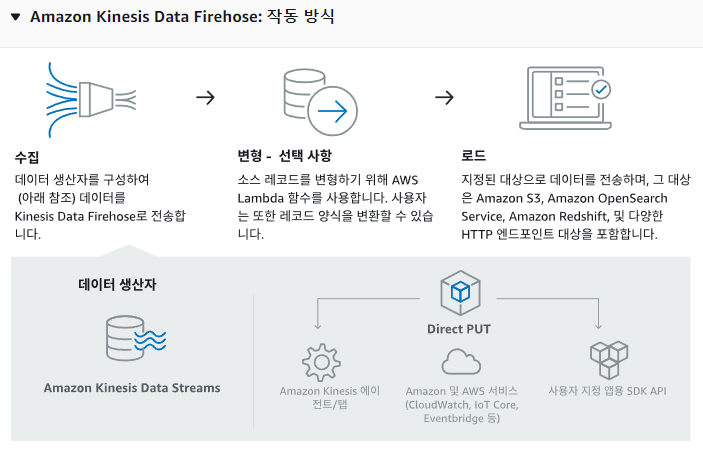

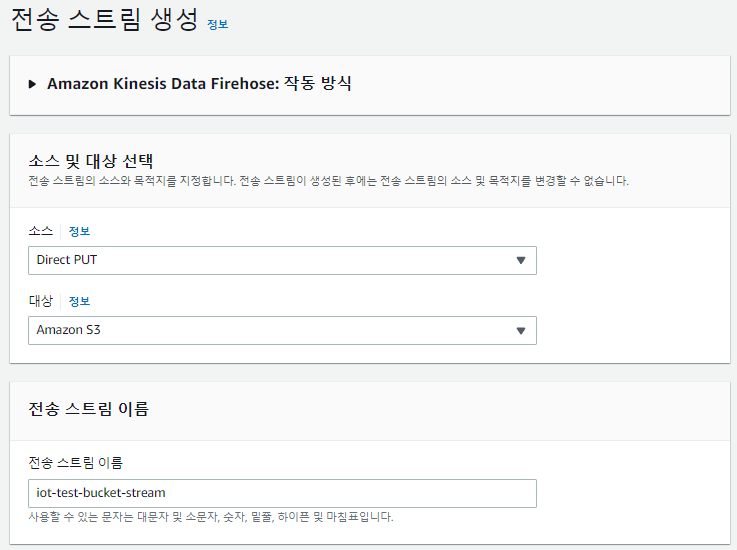

- Kinesis Data Firehose 생성

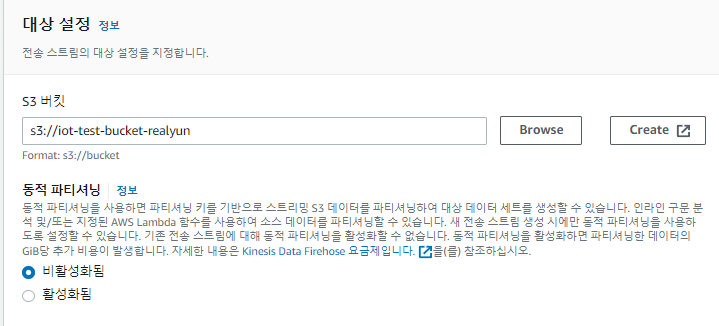

Browse를 눌러 위에서 생성했던 버킷 지정해준다.

위와 같이 추가 설정을 진행한 후 생성을 클릭

- IoT Core 규칙 생성

위와 같이 규칙 작업을 추가해준다.

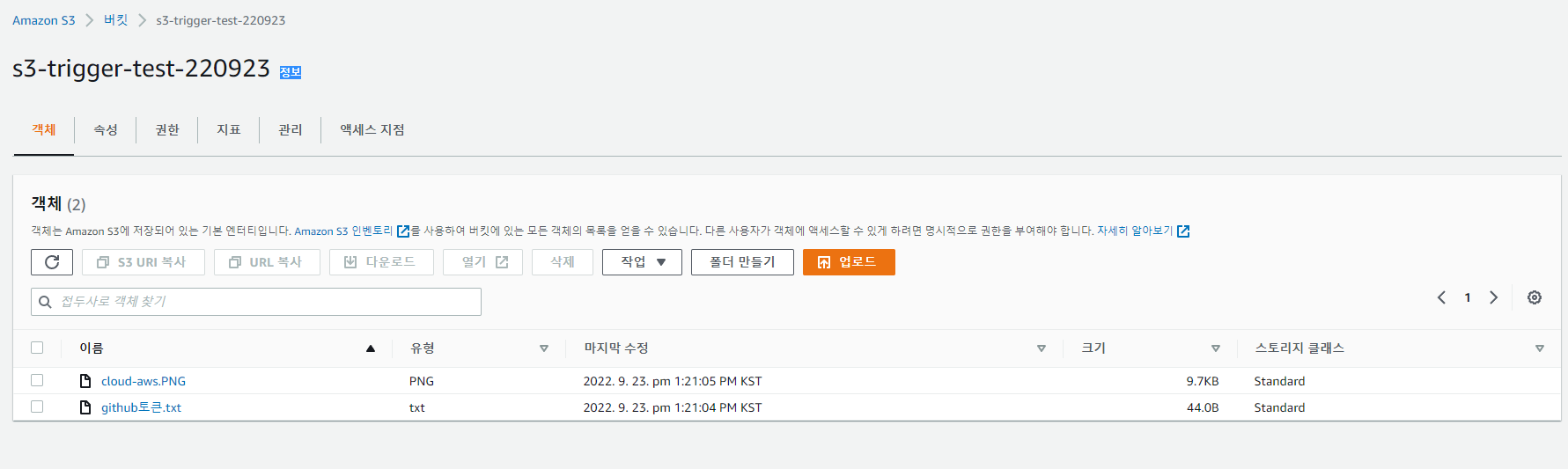

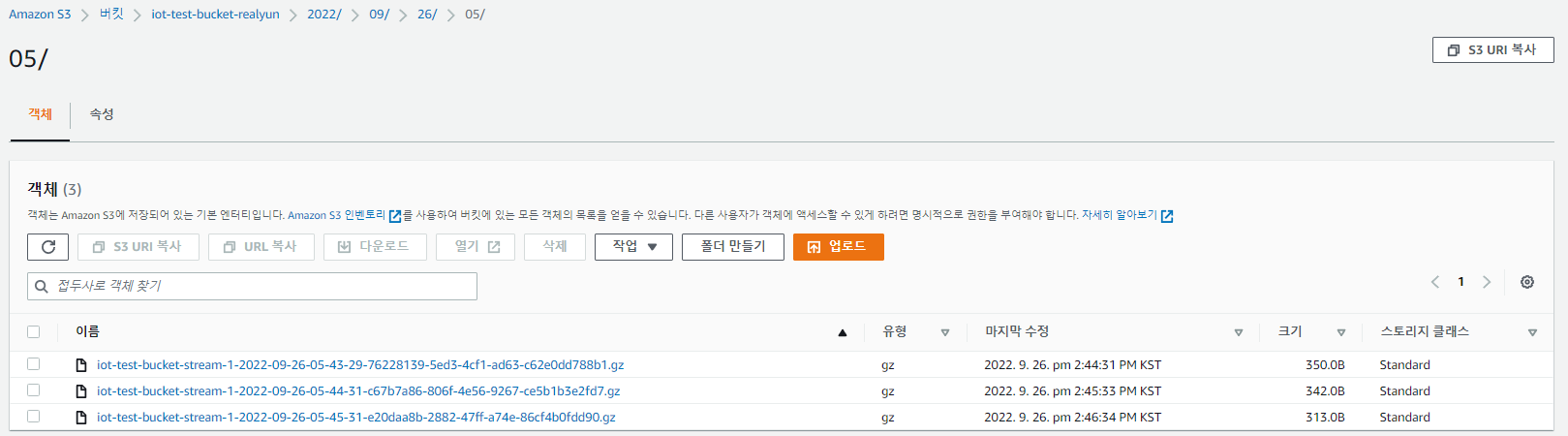

- S3 버킷 확인하기

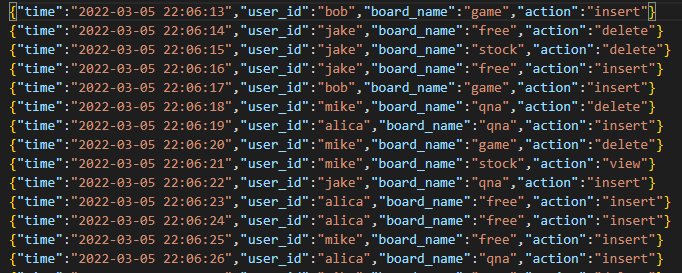

.gz 파일 객체 확인

→ 디바이스의 메시지가 S3 데이터 레이크에 저장되었음을 확인.

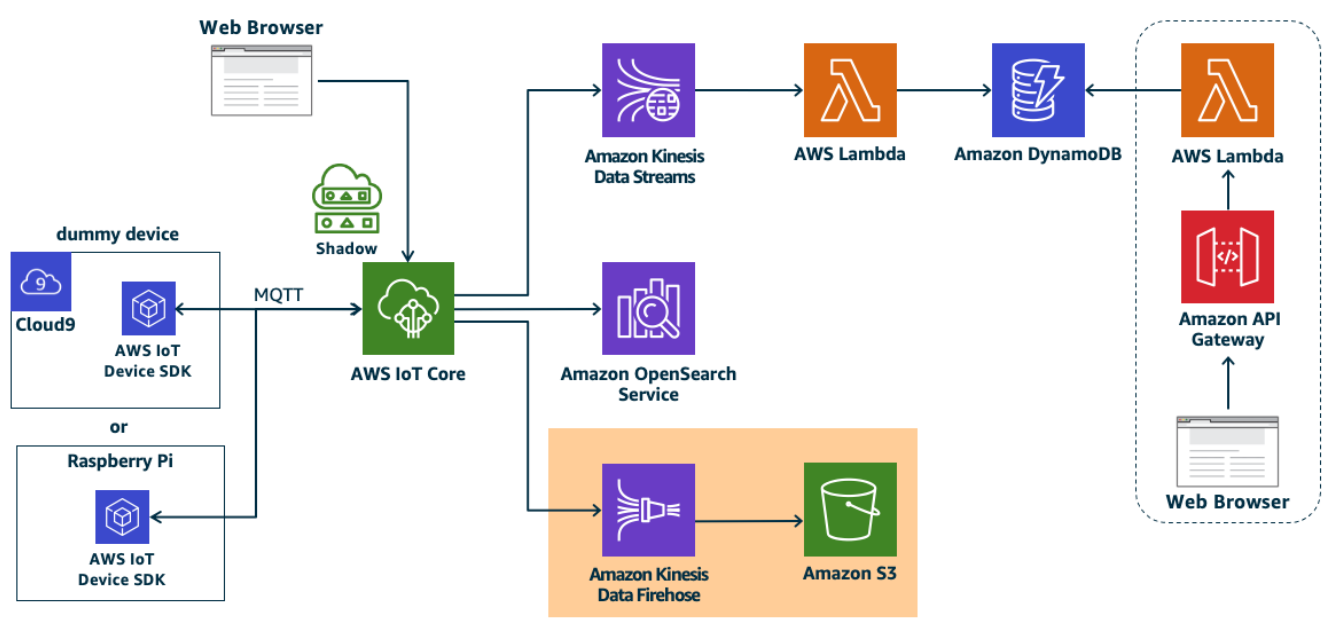

❗ 위의 설계도 처럼 사용하기도 하지만 보통 OpenSearch의 경우 비싸 많이 사용하지 않는다. 오히려 S3 뒤쪽으로 분석 쪽 서비스들을 더해 주로 사용하게 될듯! ❗

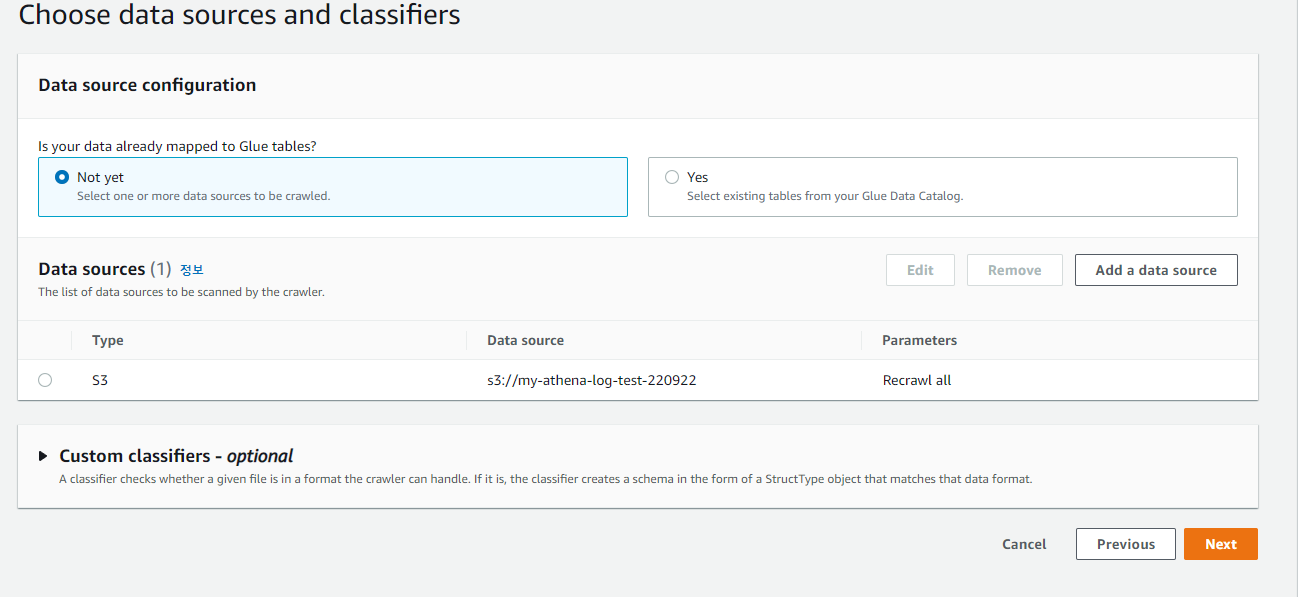

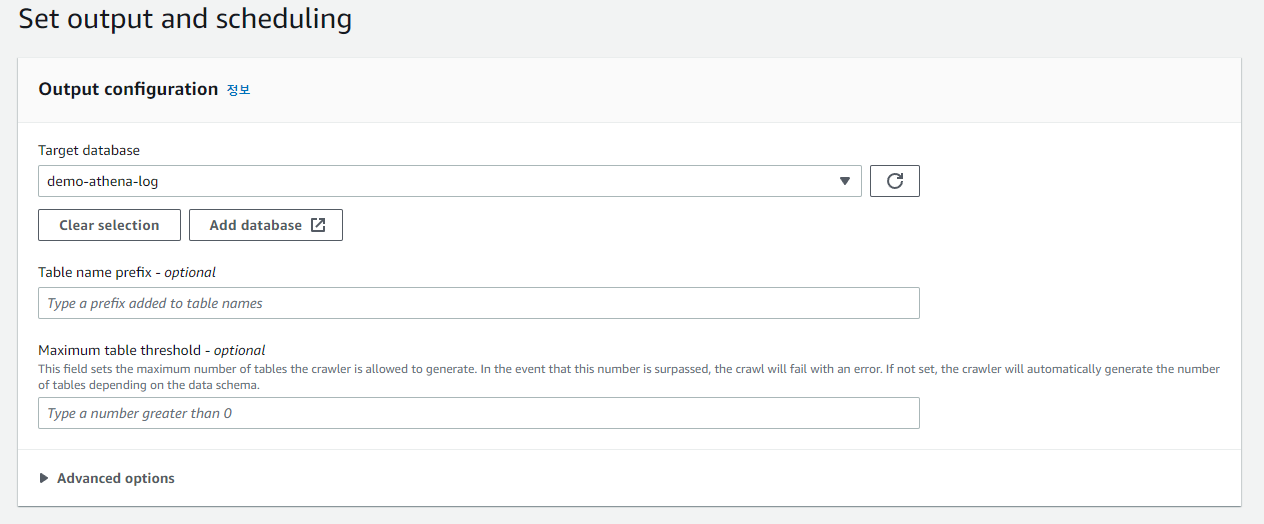

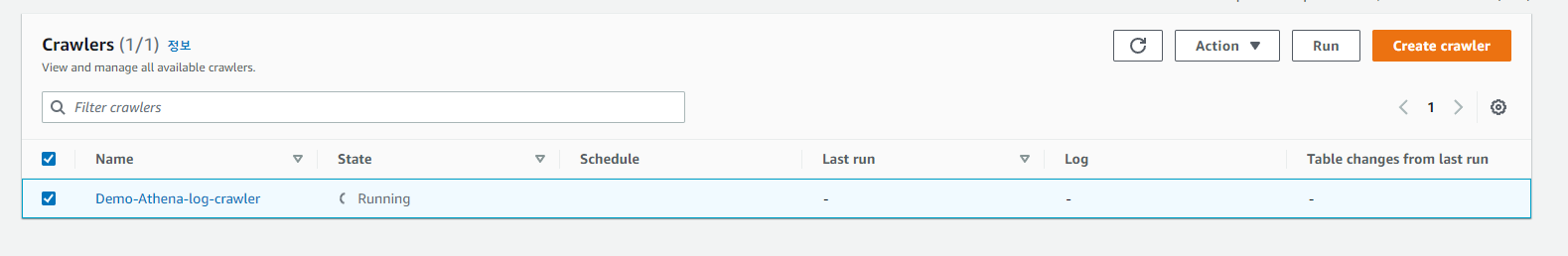

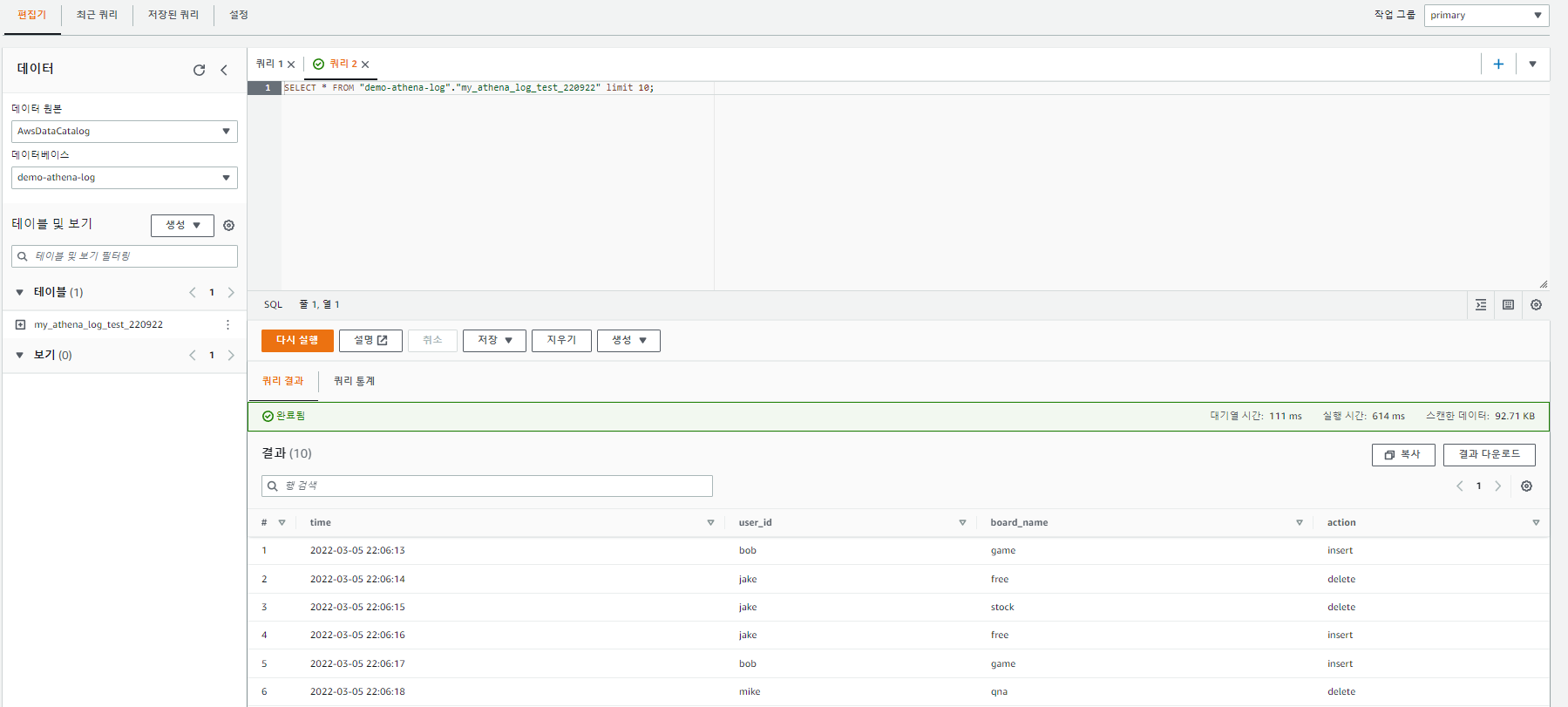

(S3 + Glue + Athena로 분석하고 QuickSight로 시각화)

'Cloud > AWS' 카테고리의 다른 글

| [AWS] EC2로 MQTT 통신 테스트 (0) | 2022.09.27 |

|---|---|

| [AWS] Amazon Kinesis 개념 (0) | 2022.09.26 |

| [AWS] IoT Core 살펴보기 -3(실시간 시각화) (0) | 2022.09.26 |

| [AWS] IoT Core 살펴보기 -2(애플리케이션용 DB) (0) | 2022.09.26 |

| [AWS] IoT Core 살펴보기 -1(디바이스 설치) (1) | 2022.09.26 |